À l’occasion du CES 2026, Nvidia a présenté sa nouvelle architecture pour les data centers baptisée Rubin, conçue autour de six nouvelles puces pour dominer le marché de l’intelligence artificielle. Cette plateforme, déjà en production, promet des gains de performance massifs et une réduction significative des coûts par rapport à la génération Blackwell.

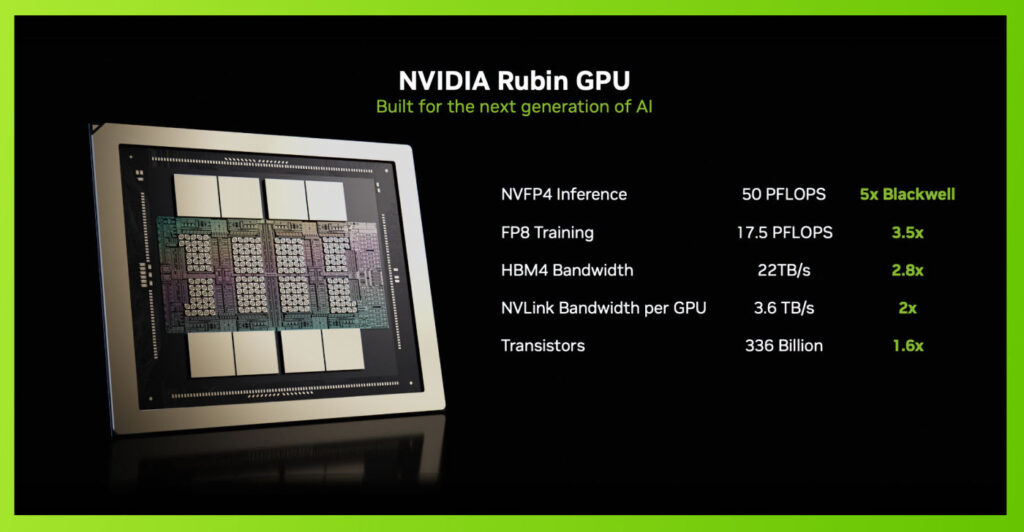

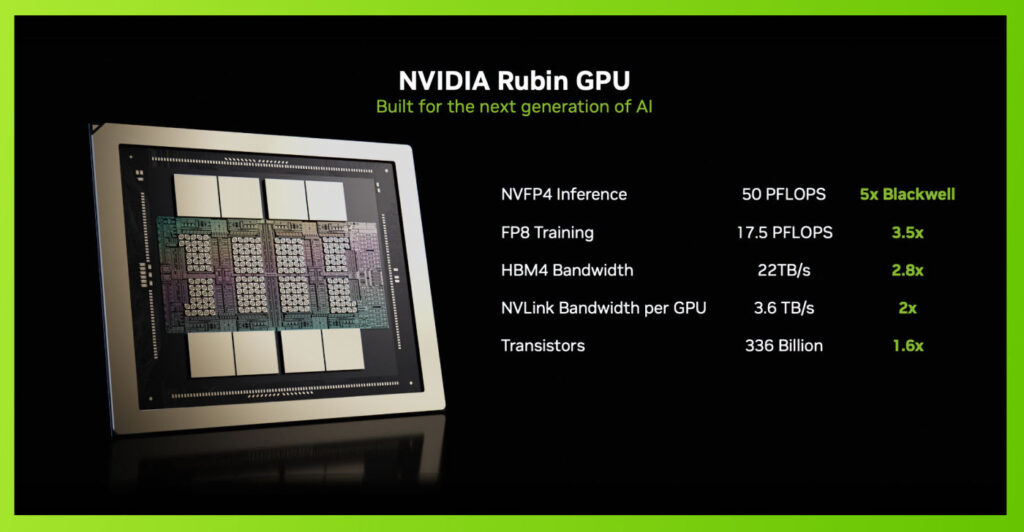

Le GPU Rubin et le CPU Vera redéfinissent la puissance de calcul

La pièce maîtresse de cette annonce est le GPU Rubin. Il intègre 336 milliards de transistors répartis sur deux puces. Il adopte la mémoire HBM4, offrant jusqu’à 288 Go de capacité par unité et une bande passante mémoire de 22 To/s. En matière de performance brute, Nvidia annonce jusqu’à 50 PFLOP en inférence (NVFP4) et 35 PFLOP en entraînement. Ces chiffres représentent respectivement des améliorations de 5 fois et 3,5 fois par rapport à l’architecture Blackwell.

Pour accompagner ce processeur graphique, Nvidia met en avant le processeur (CPU) Vera. Basé sur des cœurs Arm personnalisés Olympus, il affiche les caractéristiques suivantes :

- 227 milliards de transistors

- 88 cœurs et 176 threads grâce au « Spatial Multi-Threading »

- Jusqu’à 1,5 To de mémoire LPDDR5x

- Une bande passante mémoire de 1,2 To/s

Nvidia affirme que le CPU Vera double les capacités de traitement de données et de compression en comparaison avec à la puce Grace. La connexion entre les puces est assurée par le lien NVLink-C2C, atteignant 1,8 To/s.

Le rack Vera Rubin NVL72 vise l’efficacité énergétique maximale

L’architecture Rubin prend tout son sens à l’échelle du système complet, notamment avec le rack Vera Rubin NVL72. Cette configuration rassemble 72 GPU Rubin et 36 CPU Vera, interconnectés via la technologie NVLink 6. Ce système délivre une puissance de 3,6 EFLOPS en inférence et 2,5 EFLOPS en entraînement, soutenu par une capacité mémoire totale impressionnante combinant HBM4 et LPDDR5x.

L’objectif principal de cette débauche de puissance est l’efficacité économique. Nvidia promet une division par dix du coût des tokens d’inférence. De plus, l’entraînement de modèles complexes (MoE) nécessiterait quatre fois moins de GPU qu’avec la génération précédente.

Pour supporter ces flux de données, l’infrastructure réseau évolue également. La technologie NVLink 6 offre 3,6 To/s de bande passante bidirectionnelle par GPU. Côté connectivité externe, Nvidia déploie le ConnectX-9 (jusqu’à 1,6 To/s par GPU) et le DPU BlueField-4, ainsi que des commutateurs Spectrum-X Ethernet Photonics.

Contrairement aux prévisions initiales qui tablaient sur le second semestre, Nvidia confirme que la plateforme Rubin est entrée en pleine production dès le premier trimestre de 2026. La disponibilité pour les partenaires reste fixée au second semestre, mais les déploiements initiaux débuteront tôt dans l’année. Les géants du cloud comme AWS (Amazon), Google Cloud, Microsoft et Oracle, ainsi que des partenaires spécialisés comme CoreWeave et Lambda, seront les premiers à exploiter cette nouvelle architecture