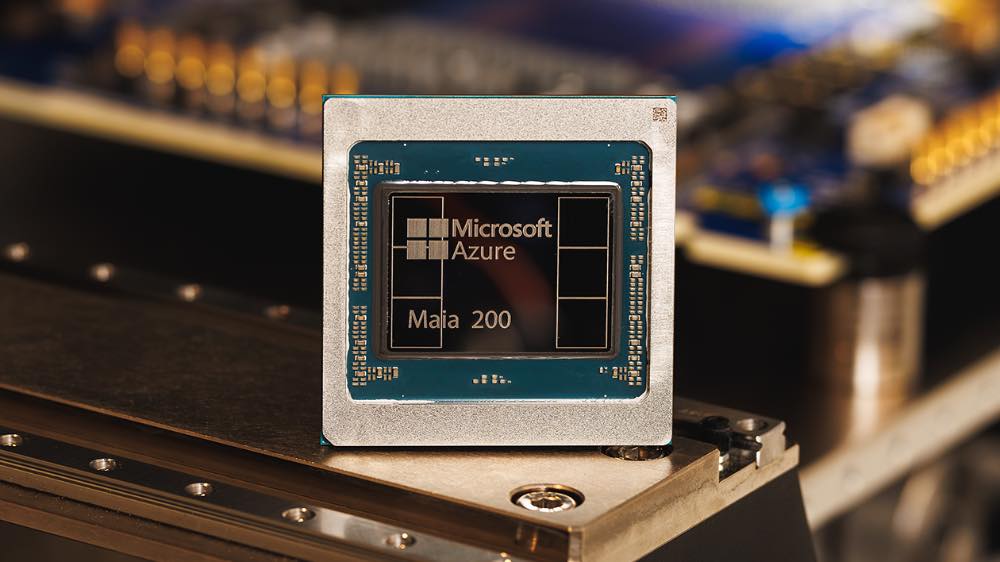

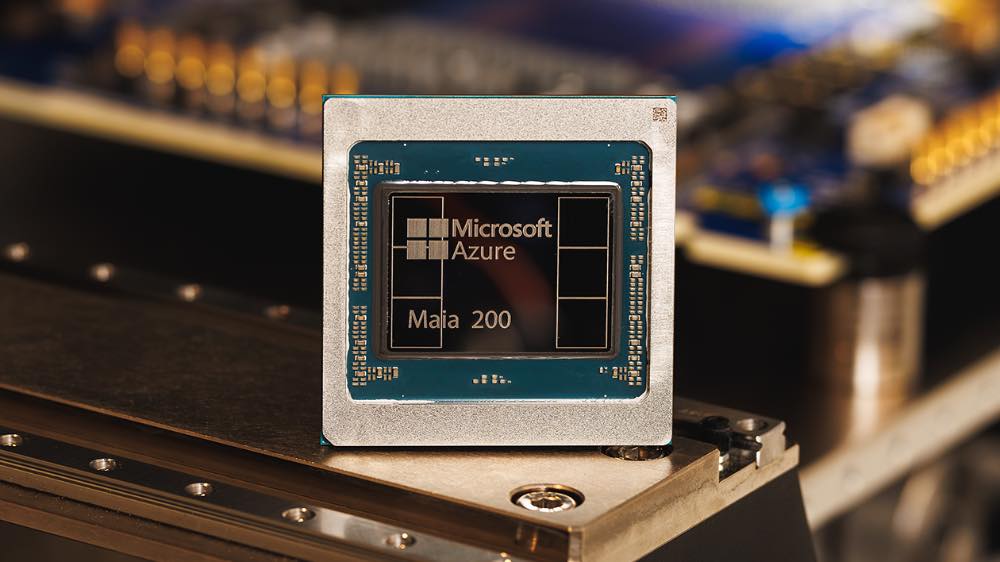

Microsoft a annoncé le lancement de Maia 200, une puce dédiée à l’inférence en intelligence artificielle. L’entreprise présente cet accélérateur comme une brique conçue pour améliorer l’efficacité économique de la génération de jetons, c’est-à-dire l’étape où un modèle de langage produit du texte, du code ou des réponses en temps réel. En pratique, cette annonce s’inscrit dans une tendance de fond : les grands acteurs du cloud investissent de plus en plus dans leur propre silicium afin de maîtriser leurs coûts, leurs performances et leur dépendance vis-à-vis des fournisseurs historiques.

À quoi sert un accélérateur d’inférence comme Maia 200

Dans l’IA générative, l’inférence correspond à l’exécution d’un modèle déjà entraîné. C’est la phase la plus visible pour les utilisateurs (chatbots, assistants, génération d’images, outils de résumé), et souvent l’une des plus coûteuses à grande échelle. À chaque requête, le modèle “calcule” des jetons successifs. À l’échelle d’un service cloud, une amélioration marginale du coût par jeton peut se traduire par un impact important sur la facture énergétique, la densité de serveurs nécessaires et, in fine, la rentabilité du service.

Un accélérateur d’inférence vise donc à exécuter ces calculs plus vite, avec une meilleure efficacité énergétique, et à optimiser l’usage de la mémoire et des interconnexions. Cela intéresse surtout les opérateurs de centres de données, les fournisseurs de plateformes IA et les entreprises qui consomment des modèles via des services cloud, plutôt que le grand public directement.

Performances annoncées : FP4 et FP8 au cœur du positionnement

Selon Microsoft, Maia 200 délivre plus de 10 PFLOPS en précision 4 bits (FP4) et plus de 5 PFLOPS en 8 bits (FP8). Les PFLOPS (pétaflops) mesurent une capacité de calcul en opérations flottantes par seconde, tandis que FP4 et FP8 renvoient à des formats de précision réduite. Ces formats sont de plus en plus utilisés pour l’inférence, car ils peuvent accélérer les calculs et limiter la bande passante mémoire, à condition que les modèles et les bibliothèques logicielles soient correctement optimisés.

Microsoft affirme également que Maia 200 peut faire fonctionner « les plus grands modèles actuels », tout en conservant une marge pour des modèles plus volumineux à l’avenir. L’entreprise ne détaille pas, dans ce communiqué, les tailles de modèles ciblées, les conditions de test, ni les métriques comparatives (latence, débit, consommation). Comme souvent sur ce type d’annonce, ces éléments pèseront lourd dans l’évaluation concrète de la puce par les équipes d’ingénierie et les clients cloud.

Comparaisons avec Trainium et TPU : des affirmations à cadrer

Le communiqué avance aussi une comparaison directe avec des puces concurrentes. Microsoft présente Maia 200 comme « le silicium tiers le plus performant de tous les hyperscalers » et indique, d’après ses propres éléments, des performances FP4 trois fois supérieures à celles de la troisième génération d’Amazon Trainium, ainsi que des performances FP8 supérieures à celles de la septième génération de TPU de Google. Là encore, ces écarts dépendent fortement des scénarios de mesure : types de modèles, niveaux de quantification, paramètres d’optimisation, batch size, contraintes de mémoire, interconnexions, et pile logicielle associée.

Pour le marché, ces annonces illustrent surtout la bataille sur l’inférence : Nvidia reste très présent avec ses GPU pour centres de données, tandis qu’AMD et Intel cherchent aussi leur place. En parallèle, Google (TPU), Amazon (Trainium/Inferentia) et Microsoft renforcent leurs offres internes afin d’alimenter leurs services et de proposer des alternatives dans le cloud. À côté des usages “assistant” et productivité, certains acteurs poussent aussi des modèles orientés sciences et simulation : Nvidia a par exemple récemment mis en avant des modèles d’IA pour la météorologie et l’anticipation d’événements extrêmes, un sujet abordé dans cet article : Météo : Nvidia dévoile de nouveaux modèles d’IA capables d’anticiper les tempêtes.

Déploiement dans Azure : un premier ancrage en région US Central

Microsoft indique que Maia est déjà déployée dans la région US Central de son infrastructure cloud. Les premiers systèmes Maia 200 serviraient notamment à trois usages internes : alimenter de nouveaux modèles de l’équipe “Microsoft Superintelligence”, accélérer des projets liés à Microsoft Foundry et soutenir Microsoft Copilot.

Cette précision sur la disponibilité géographique donne un indice sur la stratégie de déploiement : démarrer dans une région, valider l’exploitation à grande échelle (refroidissement, maintenance, rendement, stabilité logicielle), puis étendre progressivement. En revanche, le communiqué ne précise pas si, ni quand, Maia 200 sera proposé aux clients Azure comme option matérielle, ni sous quelle forme (instances dédiées, offre managée, accès via une plateforme d’inférence). Microsoft ne communique pas non plus de prix, de calendrier de généralisation, ni de volumes de production.

Une stratégie « silicium + modèles + applications » pour verrouiller la chaîne

L’entreprise met en avant un modèle intégré associant le matériel, le développement des modèles et l’optimisation des applications. L’idée est simple : si un acteur contrôle à la fois la puce et la pile logicielle (frameworks, compilateurs, bibliothèques, orchestration), il peut mieux adapter le matériel aux besoins réels, et inversement ajuster les modèles pour exploiter au mieux les capacités du silicium.

Dans cette logique, Microsoft explique que l’exécution de charges IA « parmi les plus exigeantes » lui permet d’aligner plus étroitement la conception de ses puces, le développement de ses modèles et l’optimisation des applications. Autrement dit, Maia 200 n’est pas présentée comme un produit isolé, mais comme un élément d’architecture destiné à servir des services maison (comme Copilot) et, potentiellement, des offres cloud.

Pour quel public et quels usages concrets

Maia 200 vise d’abord les usages à grande échelle : assistants IA intégrés aux suites bureautiques, outils de recherche et de synthèse, génération de code, automatisation de tâches, ou encore déploiement de modèles spécialisés dans des organisations. Les bénéficiaires directs sont les équipes qui exploitent des modèles en production, où la facture d’inférence dépend du nombre de requêtes, de la latence attendue et des contraintes de disponibilité.

Pour les entreprises clientes, l’enjeu n’est pas seulement la puissance brute, mais la capacité à obtenir un coût stable par requête, une latence prévisible, et des outils logiciels robustes pour déployer, surveiller et mettre à jour les modèles. Sur ce point, Microsoft ne donne pas de détails techniques sur la pile logicielle associée à Maia 200, ni sur les mécanismes d’optimisation (quantification, compilation, kernels spécialisés, gestion mémoire, interconnexion entre accélérateurs).

Informations manquantes : prix, disponibilité et spécifications détaillées

À ce stade, plusieurs éléments importants ne sont pas précisés dans le communiqué. Microsoft ne communique pas le prix de Maia 200, ni les conditions d’accès pour les clients. L’entreprise ne détaille pas non plus la consommation énergétique, la configuration des serveurs, le nombre d’accélérateurs par nœud, la bande passante mémoire, ou encore les performances mesurées sur des modèles et charges de travail standardisées. Autant d’indicateurs qui permettront de situer Maia 200 face aux solutions GPU et aux puces IA concurrentes, au-delà des PFLOPS théoriques.

La suite dépendra donc des annonces sur l’intégration dans Azure, des retours d’expérience en production et d’éventuels benchmarks plus documentés. Si Microsoft confirme l’accès à Maia 200 via des offres cloud, l’accélérateur pourrait devenir un levier supplémentaire pour optimiser l’inférence des services maison, tout en élargissant les options disponibles pour les entreprises qui déploient des modèles à grande échelle. En attendant, l’annonce illustre un mouvement clair : les hyperscalers considèrent désormais le silicium comme un élément stratégique pour soutenir