TENDANCES

Comparateur

- AUTO

OpenAI, responsable de ChatGPT, marque un tournant stratégique en dévoilant gpt-oss-120b et gpt-oss-20b, deux grands modèles de langage (LLM) open source. Ce sont deux modèles de raisonnement pour l’intelligence artificielle et les premiers à être ouverts depuis GPT-2 qui remonte à 2019.

La stratégie d’OpenAI mise sur la diversité des besoins utilisateurs. Le modèle gpt-oss-120b, plus volumineux et performant, fonctionne sur une seule carte graphique Nvidia. La version gpt-oss-20b, plus lègère, peut tourner sur un ordinateur portable standard équipé de 16 Go de RAM.

Cette approche permet d’adresser aussi bien les utilisateurs disposant de ressources limitées que ceux ayant accès à des ordinateurs plus puissants. OpenAI qualifie ces modèles de dernière génération selon plusieurs critères de comparaison des modèles ouverts.

L’originalité de cette approche réside dans la capacité des modèles ouverts à communiquer avec les modèles propriétaires d’OpenAI dans le cloud. Lorsque les modèles locaux atteignent leurs limites, notamment pour le traitement d’images, ils peuvent automatiquement faire appel aux solutions plus performantes de l’entreprise.

Cette stratégie hybride offre une flexibilité aux utilisateurs tout en préservant les revenus d’OpenAI sur ses modèles les plus avancés.

Cette décision marque une rupture avec la philosophie récente d’OpenAI, qui privilégiait une approche propriétaire et fermée depuis plusieurs années. Cette stratégie avait permis à l’entreprise de créer un modèle économique solide en vendant l’accès à ses modèles via une API aux entreprises et développeurs.

Sam Altman, patron d’OpenAI, avait reconnu en janvier que son entreprise s’était trouvée « du mauvais côté de l’histoire » concernant le côté open source de ses technologies. Cette autocritique révèle une prise de conscience face à la montée en puissance des entreprises chinoises pour l’IA, notamment DeepSeek, Qwen d’Alibaba et Moonshot AI, qui ont développé certains des modèles ouverts les plus performants.

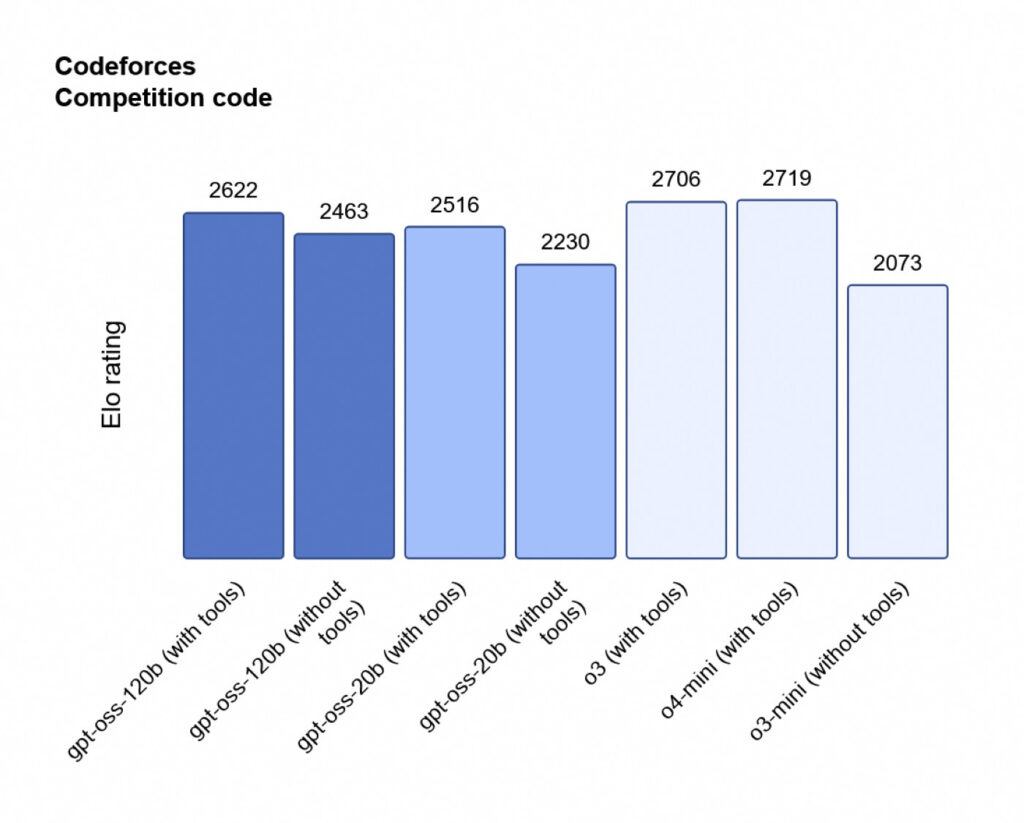

Les premiers benchmarks révèlent des résultats encourageants pour les nouveaux modèles d’OpenAI. Sur Codeforces, un test de programmation compétitive, gpt-oss-120b obtient un score de 2 622 points tandis que gpt-oss-20b atteint 2 516 points. Ces performances surpassent le modèle R1 de DeepSeek tout en restant inférieures aux modèles o3 et o4-mini d’OpenAI.

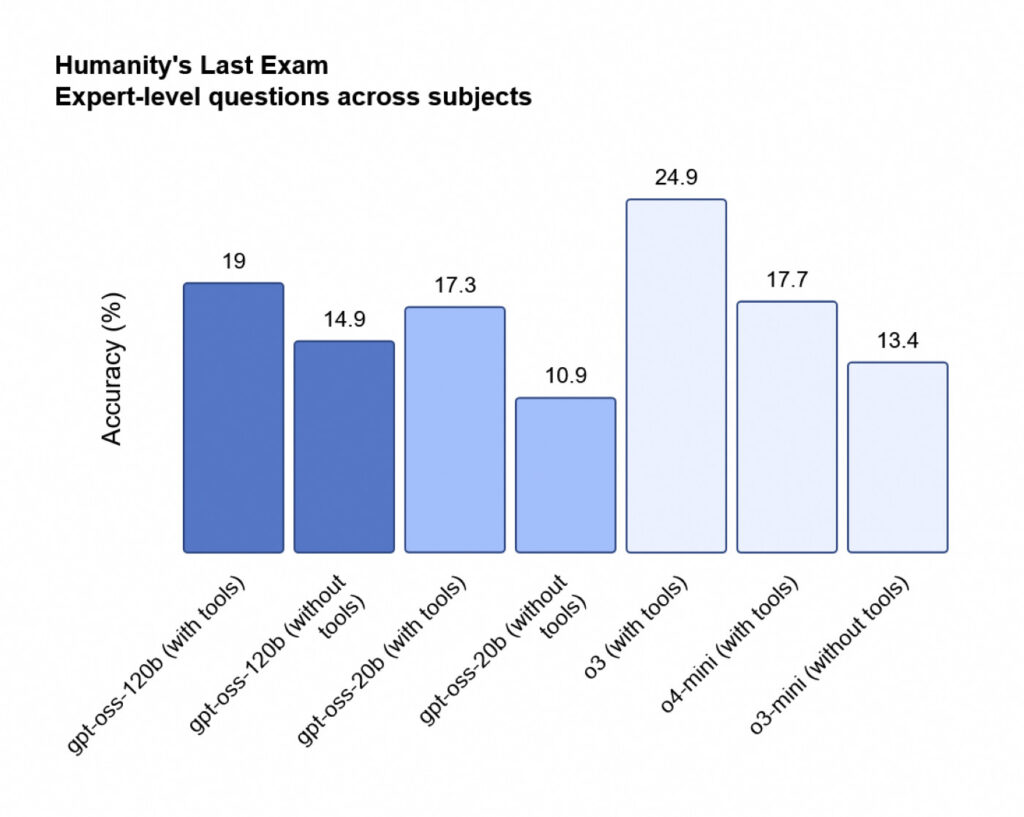

Le test sur Humanity’s Last Exam, un test complexe couvrant diverses disciplines, donne des résultats plus modestes. Le modèle gpt-oss-120b obtient 19 % de réussite contre 17,3 % pour son petit frère. Ces scores, bien qu’inférieurs à o3, dépassent néanmoins les modèles ouverts concurrents de DeepSeek et Qwen.

Paradoxalement, les modèles ouverts d’OpenAI souffrent d’un taux d’hallucinations significativement plus élevé que leurs homologues propriétaires. Sur PersonQA, le benchmark interne d’OpenAI mesurant la précision des connaissances sur les personnalités, gpt-oss-120b et gpt-oss-20b affichent respectivement 49 % et 53 % d’hallucinations.

Ces chiffres contrastent fortement avec les 16 % du modèle o1 et les 36 % d’o4-mini. OpenAI explique ce phénomène par la taille réduite de ces modèles, qui disposent de moins de connaissances que les modèles de pointe et tendent naturellement à halluciner davantage.

Les nouveaux modèles d’OpenAI bénéficient d’une architecture mixture-of-experts (MoE) qui optimise l’utilisation des paramètres. Pour gpt-oss-120b, doté de 117 milliards de paramètres au total, seuls 5,1 milliards sont activés par token, garantissant une efficacité de calcul optimale.

L’entraînement de ces modèles repose sur un apprentissage par renforcement haute performance, processus similaire à celui utilisé pour les modèles o d’OpenAI. Cette méthode permet aux modèles de développer un processus de chaîne de pensée comparable, prenant le temps nécessaire pour élaborer leurs réponses.

En outre, grâce à leur processus d’entraînement avancé, ces modèles excellent dans le pilotage d’agents IA. Ils peuvent appeler des outils externes comme la recherche Web ou l’exécution de code Python dans leur processus de raisonnement. Cependant, ils restent limités au texte et ne peuvent traiter ni images ni audio, contrairement aux autres modèles d’OpenAI.

Cette spécialisation textuelle représente un compromis assumé entre performance et polyvalence, permettant une optimisation ciblée sur les tâches de raisonnement pur.

OpenAI a choisi la licence Apache 2.0 pour ces modèles, considérée comme l’une des plus permissives du secteur. Cette décision autorise les entreprises à monétiser ces modèles sans autorisation préalable ni redevance, favorisant une adoption large.

Néanmoins, contrairement aux approches totalement ouvertes d’autres groupes comme AI2, OpenAI ne publiera pas les données d’entraînement utilisées pour créer ces modèles. Cette réserve maintient un certain contrôle sur la reproduction exacte de la technologie tout en offrant une liberté d’usage commerciale.

Les modèles gpt-oss-120b et gpt-oss-20b sont disponibles gratuitement au téléchargement sur GitHub et Hugging Face (120b et 20b)

Après les États-Unis en septembre, Meta annonce le lancement européen de Vibes. Les vidéos générées par...

Entre box opérateur, Smart TV et clés HDMI, l’usage du streaming 4K explose. Les plateformes se multiplient, les formats vidéo...

Le géant chinois de la fast-fashion Shein a évité de justesse une suspension de ses activités en France en purgeant son site...

De nombreux utilisateurs ont cru à une panne majeure de YouTube en découvrant une page blanche à la place de leurs contenus...

Free Mobile a passé un cap : il devient l’opérateur avec le plus d’antennes 3G. Il dépasse ainsi Orange, SFR et Bouygues...