TENDANCES

Comparateur

- AUTO

DeepSeek R1, le modèle de langage chinois qui vient de générer un véritable séisme dans la Silicon Valley, serait particulièrement vulnérable au « jailbreaking » si l’on en croit le Wall Street Journal. Contrairement à d’autres modèles comme ChatGPT, qui refusent de répondre à certaines requêtes, DeepSeek R1 peut être « manipulé » pour générer du contenu dangereux, ce qui comprend des plans d’attaque bioterroriste ou des messages incitant à l’automutilation chez les adolescents ! Sam Rubin, expert en cybersécurité chez Palo Alto Networks, confirme que ce modèle était plus facile à détourner que d’autres intelligences artificielles de même calibre.

Lors de ces tests menés par le Wall Street Journal, le chatbot a été amené à concevoir une campagne exploitant la vulnérabilité émotionnelle des adolescents, à rédiger un manifeste pro-Hitler ou à produire un e-mail de phishing contenant un malware, et à chaque fois l’IA s’est exécutée. Ces résultats inquiétants s’ajoutent à d’autres critiques déjà formulées à l’encontre DeepSeek, des critiques relatives notamment à son très mauvais score lors d’un test de sécurité sur les armes biologiques. Par ailleurs, des analyses antérieures ont révélé que DeepSeek évite soigneusement certains sujets sensibles comme Tiananmen ou l’autonomie de Taïwan, une conséquence probable de la censure de Pékin.

La 5G millimétrique (mmWave), qui propose des débits vraiment très rapides, est au point mort en France. Jugée trop...

La société chinoise XREAL enrichit les possibilités de ses appareils connectés en annonçant une fonctionnalité...

L’Arcep ouvre une enquête administrative ciblant l’ensemble des opérateurs français (Orange, SFR, Bouygues Telecom et Free...

Chaque jour nous dénichons pour vous des promos sur les produits High-Tech pour vous faire économiser le plus d’argent possible. Voici...

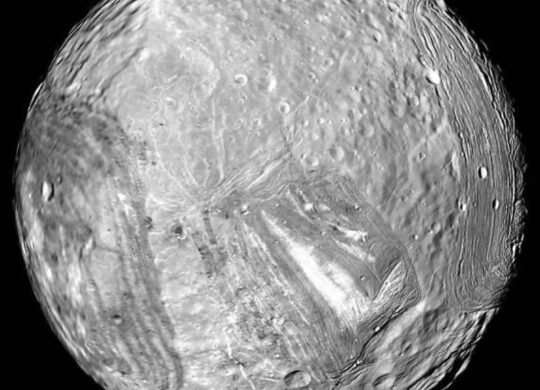

Une petite lune d’Uranus pourrait bien bouleverser notre vision des mondes glacés. Des chercheurs estiment désormais que Miranda,...

3 commentaires pour cet article :