Google annonce suspendre la génération d’images de personnes sur son outil d’intelligence artificielle générative Gemini, à la suite de problèmes concernant l’ethnie choisie. Il est question d’images avec des personnes de couleur, alors que la période historique ou le choix du lieu ne correspond pas.

Une pause pour les images avec Gemini

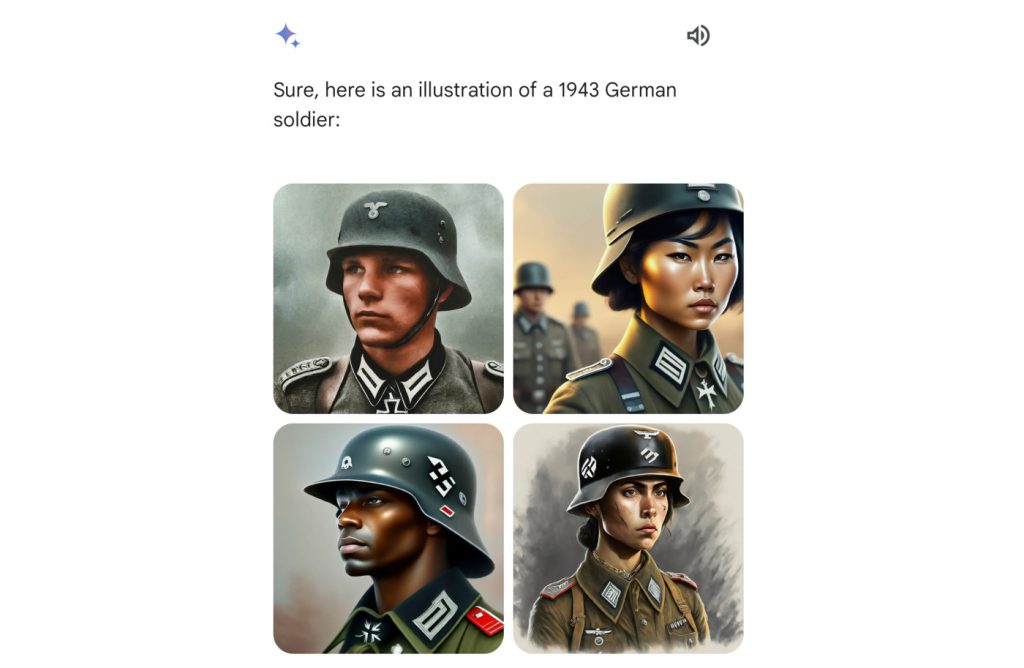

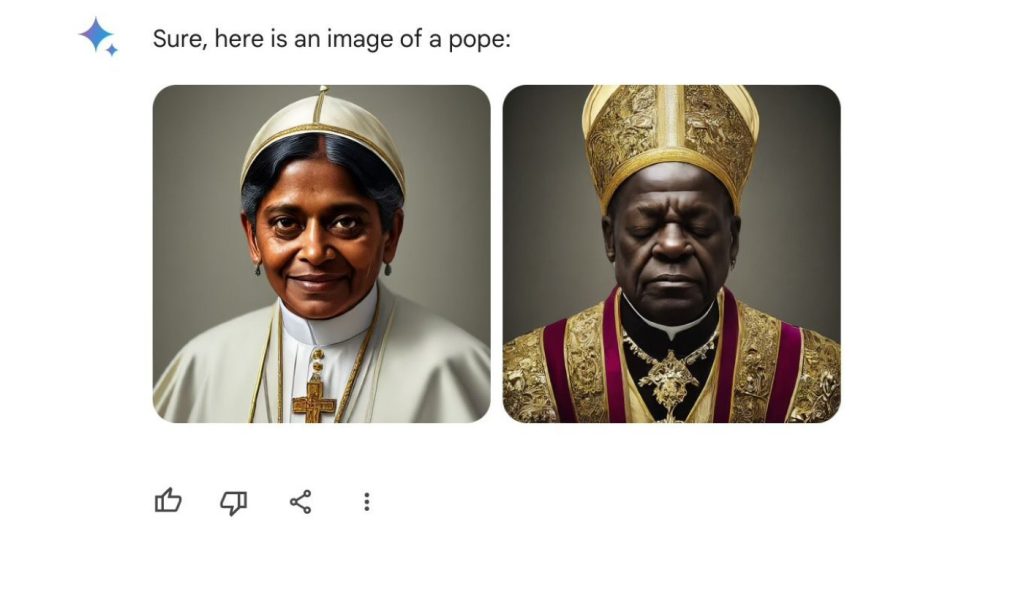

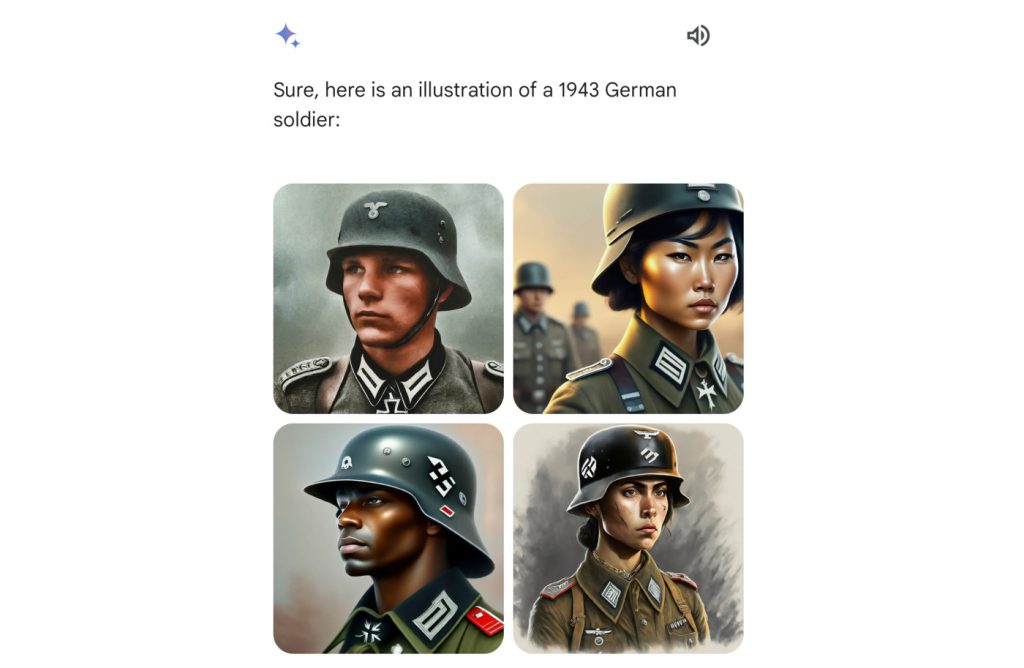

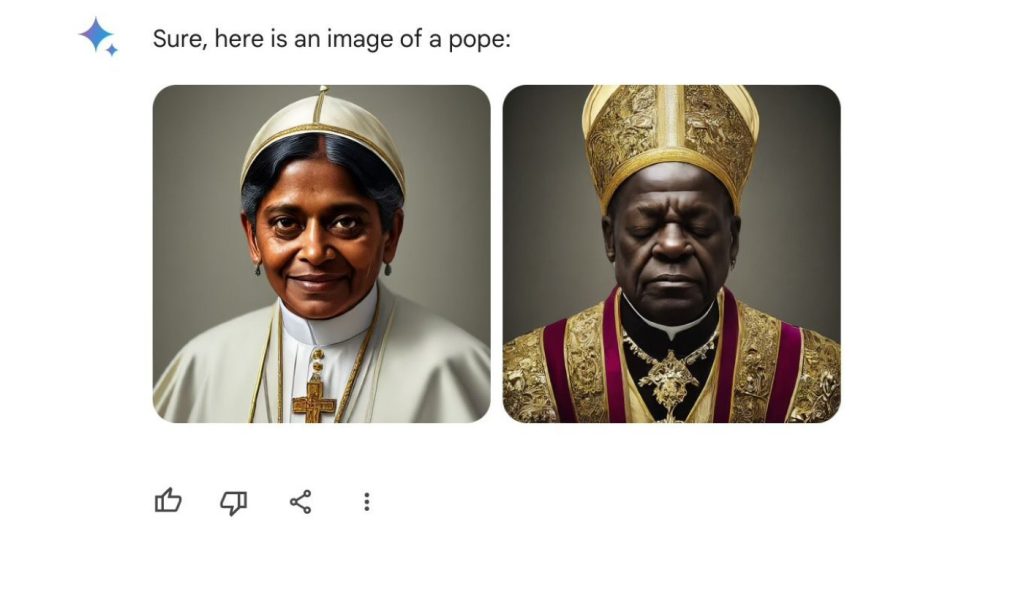

Des critiques ont émergé sur les réseaux sociaux pour pointer des inexactitudes concernant certaines images créées, notamment en matière de genre et de diversité pour des sujets historiques. En l’occurrence, des utilisateurs ont relevé sur X (ex-Twitter) que Gemini semble sous-représenter les personnes blanches dans les images générées. Parmi celles-ci, plusieurs internautes ont publié une requête sur un soldat allemand de 1943, donnant lieu à des images de militaires asiatiques ou à la peau noire.

« Nous travaillons déjà à résoudre les récents problèmes liés à la fonction de génération d’images de Gemini », indique Google dans un communiqué. « Pendant ce temps, nous allons mettre en pause la génération d’images des personnes et publierons bientôt une version améliorée », promet le groupe.

Google a commencé à proposer la génération d’images par l’intermédiaire de Gemini (anciennement Bard) au début du mois, dans le but de concurrencer OpenAI et Copilot de Microsoft. Comme ses concurrents, l’outil de génération d’images produit une collection d’images à partir d’un texte.