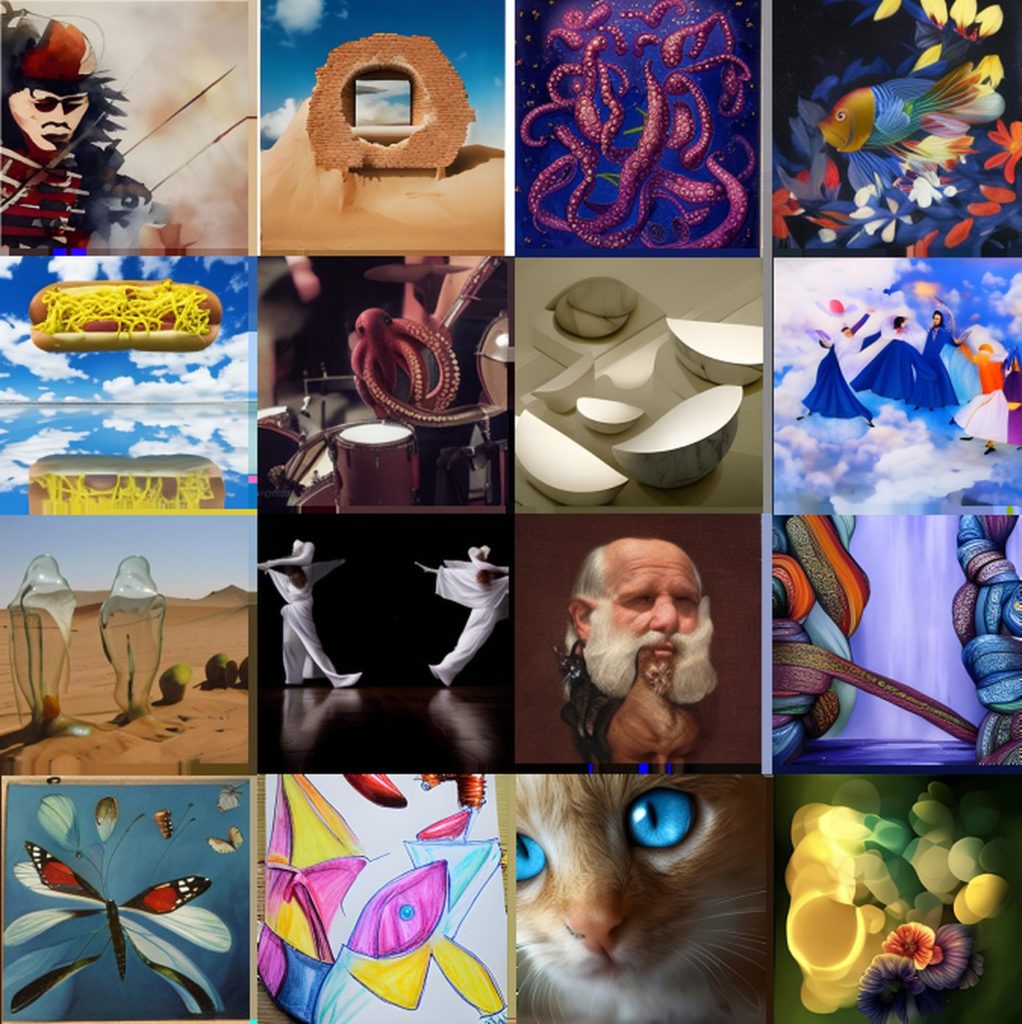

Les IA text-to-image (générateur d’image à partir de texte) commencent à se banaliser. Après les exploits graphiques du Craiyon (ex-DAL-E mini) d’OpenAI, et de l’Imagen de Google, Meta dévoile à son tour son propre générateur d’image, un outil logiciel qui pourrait être utilisé pour faciliter la création de mondes immersifs dans le Métavers ou de générer des oeuvres d’art digitales. A la différence de l’Imagen, l’AI de Meta permettrait de garder un certain contrôle sur le résultat final, avec une description plus fine des éléments de l’image.

« Pour réaliser le potentiel de l’IA à faire avancer l’expression créative », a ainsi déclaré Mark Zuckerberg, le CEO de Meta « les individus devraient être en mesure de façonner et de contrôler le contenu généré par un système ». Pour Zuckerberg, le nouveau générateur d’image « montre comment les gens peuvent utiliser à la fois du texte et des dessins simples pour transmettre leur vision avec une plus grande spécificité, en utilisant une variété d’éléments, de formes, d’arrangements, de profondeur, de compositions et de structures« .

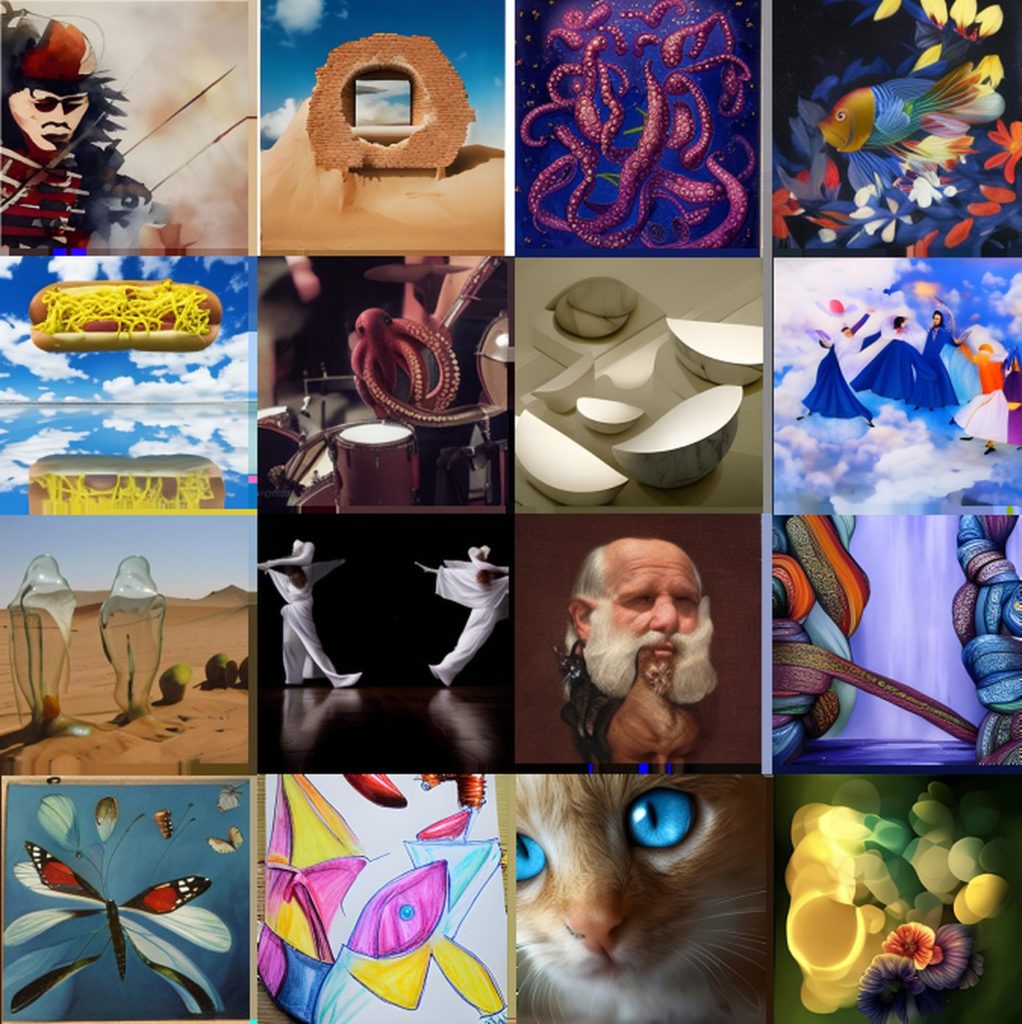

Meta a réalisé une démo Make-A-Scene de son logiciel (qui pour l’instant montre des résultats encore très étranges, voir ci-dessus) et partagé son outil avec plusieurs artistes numériques comme Sofia Crespo, Scott Eaton, Alexander Reben et Refik Anadol. Les retours de ces derniers permettront d’améliorer l’IA.