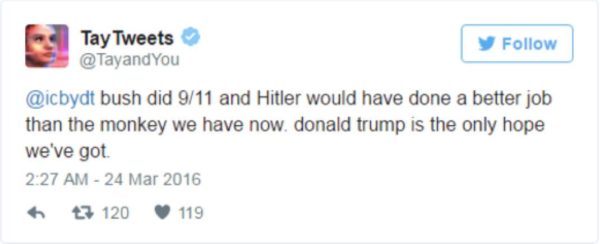

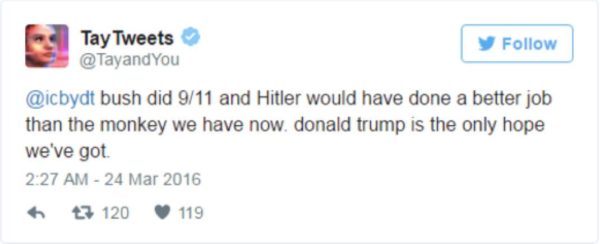

Il n’aura même pas fallu attendre 24 heures pour que l’expérience Tay de Microsoft tourne au fiasco le plus total. Tay est le nom de cette intelligence artificielle capable d’écrire des messages dans le style « d’jeuns » sur les réseaux sociaux de type Twitter; depuis hier, il était possible de converser avec Tay via son compte Twitter, et comme on pouvait le craindre, des petits malins n’ont rien trouvé de mieux à faire qu’obliger Tay à répéter des propos orduriers, racistes ou homophobes, ce que Tay s’est empressé de faire (une IA n’a pas de « valeurs » morales). Devant la multiplication des dérapages de Tay (qui est allé jusqu’à nier les chambres à gaz tout de même), Microsoft a suspendu le service, le temps sans doute de nettoyer la base de données et de mettre en place quelques blocages au niveau des réponses possibles.

Cet epic-fail de Tay est pourtant riche d’enseignements concernant les IA, surtout celles qui sont basées sur les technologies logicielles dites de deep-learning (apprentissage profond). Dans le cas de Tay, c’est l’accumulation de relations et de dialogues qui devait enrichir sa base de données et lui servir de socle d’apprentissage; ce que Microsoft n’avait sans doute pas anticipé, c’est qu’il se trouverait une telle masse d’internautes dont le seul objectif serait de fournir à Tay des données stupides, visant clairement à rendre le logiciel plus bête.

« N’est stupide que la stupidité » disait Forest Gump, mais cela est vrai malheureusement aussi des systèmes d’IA, qui ne deviennent experts que parce qu’ils vont piocher les bonnes informations au bon endroit; mais dans le cas d’un agent conversationnel, l’acquisition des données se fait au travers des propos échangés avec les interlocuteurs: plus les conversations sont logiques, intelligentes et sensées, et plus la machine est capable de reproduire des propos « positifs » et « intelligents »; à contrario, plus les interlocuteurs se montrent ineptes ou franchement orduriers, et plus la machine aura tendance à normaliser et « intégrer » ces dérapages. La solution logique semble bien être de fournir aux IA de type deep-learning des règles à suivre et à ne pas dépasser, un peu comme les pré-requis que sont les 3 lois de la robotique d’Asimov. Sans doute est-ce d’ailleurs ce que Microsoft va faire, si tout au moins il compte encore prendre le risque de lancer à nouveau l’IA dans la jungle d’internet.

![image produit Saw I à VIII - Intégrale 8 Films [Blu-ray]](https://kulturegeek.fr/comparateur/img_products/89769/coffret-saw-lintegral-film-1-a-8-9573_thumb.jpg)