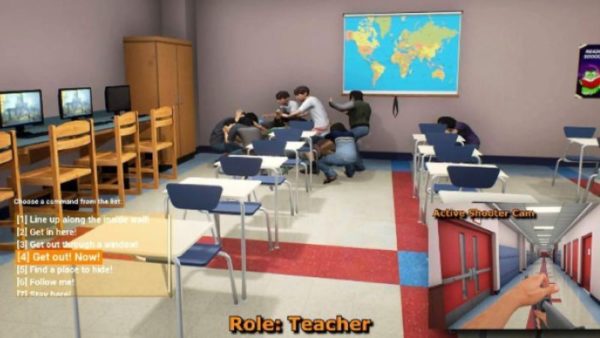

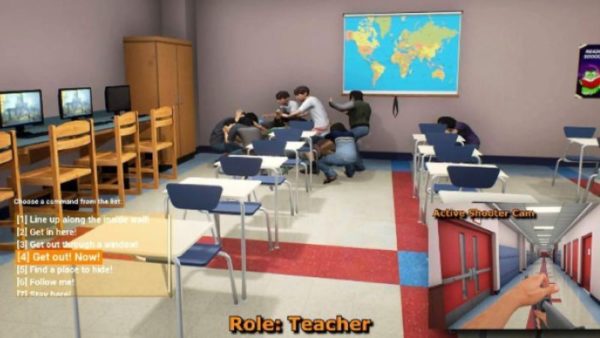

L’armée américaine et le département de la Homeland Security sont en train de mettre au point une simulation pour le moins déroutante, puisqu’il s’agit d’un outil supposé aider les professeurs à réagir au mieux dans le cas où un tireur entrerait dans leurs écoles. Plusieurs « joueurs » incarneront ainsi le professeur supposé garder les enfants à l’abri, le tireur, et le policier qui tente de l’appréhender. Et si le projet peut sembler controversé, ses créateurs espèrent en tout cas qu’il aidera les professionnels de l’éducation à être mieux préparés à ce genre d’événements.

Les enfants seront contrôlés par une IA et pourront pleurer, crier et paniquer tandis que le professeur devra gérer la situation, par exemple en verrouillant portes et fenêtres, ou en disant quoi faire aux élèves, tout en évitant le tueur en utilisant une spatialisation du son des tirs dans la simulation. Un communiqué de presse mettait en avant le moteur utilisé, qui serait celui de Mortal Kombat et BioShock. Cette simulation ne sera pas disponible pour le grand public, seulement pour un nombre réduit d’utilisateurs au départ, et devrait être lancée au printemps. Et quand on voit les moyens alloués à la préparation à de tels événements, on regrette que la prévention pure et simple, par exemple en donnant des fonds à la CDC pour mener ses études sur les armes à feu, soit laissée de côté.