Comparateur

- AUTO

Le physicien se fait de plus en plus petit sur sa chaise automatisée, mais la parole est toujours aussi libre et visionnaire. Le génie Stephen Hawking, détenteur d’une médaille Albert Einstein, se méfie de l’engouement actuel pour les intelligences artificielles. Les Siri, S-Voice, Cortana se multipliant, les films du type Her renvoyant une image « glamour » et vibrante de ces technologies encore en éclosion, la voix de ceux qui regardent un peu au delà mérite sans doute d’être entendue.

Et pour le physicien, il n’y aurait pas de quoi être très optimiste :

« Si l’on regarde plus avant, il n’y a aucunes limites fondamentales à ce qui peut être réalisé : il n’y a aucune loi de la physique des particules interdisant qu’elles soient organisées de telles façons que leurs computations soient plus avancées que l’arrangements des particules dans un cerveau humain. Une transition explosive est possible, bien que celle-ci risque de produire d’une façon bien différente des films. » Et le physicien d’imaginer des machines si intelligentes qu’elles inventeraient même des armes que nous serions incapables de comprendre.

Plus loin encore, la sentence tombe : « Bien que l’impact de l’IA à court terme dépend de qui la contrôle, l’impact sur le long-terme dépend de la possibilité que nous puissions encore la contrôler. »

L’IA de demain : une vision communicante et douce ? …

Hawking s’étonne surtout qu’aucun comité, aucune réunion des sages ne décide du sens à donner à toutes ces recherches. Au vu des risques potentiels énormes, le physicien estime qu’il s’agit là d’une faute majeure, qui reviendrait à dire à une civilisation extra-terrestre inconnue qu’elle serait la bienvenue sur terre alors même que ses objectifs pourraient être de raser la planète. Le peu de « recherches sérieuses » sur les risques inhérents à ces technologies potentiellement révolutionnaires pour l’organisation de nos sociétés futures laisse Hawkins perplexe : celui-ci voudrait voir plus de pôles de recherche dans le genre du Centre Pour l’étude des Risques de l’Université de Cambridge.

… ou l’intelligence artificielle qui ne soucie plus que de ses propres intérêts, comme le psychopathe Hal ?

S’il est aisé de hausser les épaules face à de tels propos, le progrès fulgurant des technologies informatiques depuis seulement 1/2 siècle incite à garder une certain recul, et à ne jamais dire jamais. Quel homme de 1990 aurait pu en effet imaginer que 17 ans plus tard il téléphonerait avec un iPhone tactile ou qu’un aspirateur robot ferait les sols de son salon à sa place ? Alors, du fantasme de l’IA à la « Jarvis » au cauchemar d’un monde dont nous n’aurions plus les clefs, que choisirons nous ?

C’est le premier gros « couac » depuis la commercialisation du véhicule : Tesla annonce le rappel de la totalité...

L’application TikTok ne fonctionne plus depuis au Kirghizstan, à la demande des services de sécurité de ce pays d’Asie...

Shailesh Prakash, directeur général de Google Actualités, a reconnu que les modèles actuels d’intelligence artificielle...

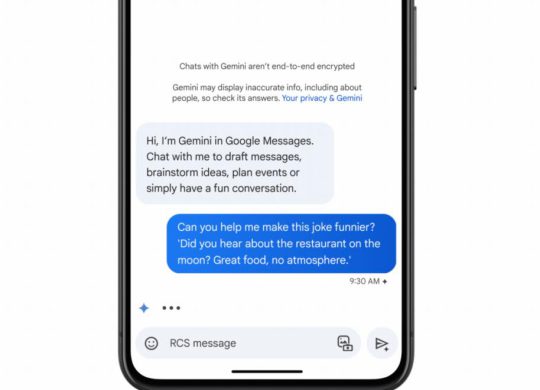

Google consolide ses activités : le CEO Sundar Pichai vient d’annoncer la création de la division Platforms and Devices qui sera en...

Jeu de l’année aux derniers Game Awards, couvert d’éloges par la critique et les joueurs, Baldur’s Gate 3 est...

« Merde quand même. Quand même » *voix de Manuel Valls*

Ma mémoire m’a joué un sale tour.